近期,欧洲计算机视觉会议(ECCV 2024)论文接收结果公布,我院白翔教授、夏天教授、唐赫副教授团队师生共有9篇论文被该会议录用,是我院在计算机视觉领域的最新研究成果!

ECCV是计算机视觉领域的三大顶级国际会议(CVPR、ICCV、ECCV)之一,本次会议共收到来自全世界的8585篇有效投稿,最终录用2395篇,录用率约27.9%。该会议每两年举办一次,汇集了科学和工业界的专业人士,今年将于9月29日至10月4日在意大利米兰召开。

OPEN: Object-wise Position Embedding for Multi-view 3D Object Detection

准确的深度信息对于提升多视图3D目标检测的性能至关重要。尽管现有的一些方法用点云深度监督取得了成功,但它们忽略了两个重要现象:1)从点云获得的深度GT通常分布在物体表面,从而缺乏3D物体中心的深度,2)对于远距离物体,对整个物体进行细粒度的深度估计更具挑战性。在本文中,我们提出了一种新的多视图3D目标检测器OPEN,其主要思想是以像素级深度图为先验,通过由GT包围盒投影得到的3D物体中心点做额外的物体深度预测监督。然后,我们利用所提出的Object-wise PE将物体深度信息进行编码,从而生成3D物体感知特征以供最终检测。大量实验验证了我们提出的方法的有效性。此外,OPEN 在nuScenes 测试基准上实现了最佳的性能。

作者:Jinghua Hou,Tong Wang,Xiaoqing Ye,Zhe Liu,Shi Gong,Xiao Tan,Errui Ding,Jingdong Wang,Xiang Bai

单位:华中科技大学,百度

Seed: A Simple and Effective 3D DETR in Point Clouds

DETR凭借其优雅的框架逐渐在2D目标检测中占据主导地位。然而,基于DETR的3D点云检测器仍然难以达到令人满意的性能。我们认为主要挑战有两个方面:1)由于点云的高度稀疏性和分布不均匀的特性,如何获得合适的Query具有挑战性;2)如何通过利用点云丰富的几何结构实现有效的Query交互尚未被充分探索。为此,我们提出了一种简单有效的3D DETR方法(SEED)用于从点云中检测3D目标,该方法主要有双重查询选择(DQS)模块和可变形网格注意力(DGA)模块。大量消融实验证明了所提出的方法的有效性。此外,SEED 在 Waymo 和 nuScenes 数据集上都实现了最先进的检测性能,说明了我们提出的方法的优越性。

作者:Zhe Liu,Jinghua Hou,Xiaoqing Ye,Tong Wang,Jingdong Wang,Xiang Bai

单位:华中科技大学,百度

Make Your ViT-based Multi-view 3D Detectors Faster via Token Compression

将基于环视图输入的3D目标检测器部署到自动驾驶等实时要求较高的任务时,推理速度慢是最关键的问题之一。尽管已有许多基于sparse query的方法被提出来提高3D检测器的效率,但它们忽略了对backbone部分的优化,仅能得到次优的效率,这一问题在使用Vision Transformer (ViT) 时尤为严重。为了解决这个问题,我们从令牌压缩的角度探索提高环视图时序3D检测效率的方案,并提出了一种简单而有效的方法,称为TokenCompression3D (ToC3D)。ToC3D首先利用历史object query作为高质量的前景先验,对其中的3D运动信息进行建模,并通过注意力机制将其与图像token进行交互,有效地确定图像token的信息密度大小并分割出前景;然后通过所提出的动态路由设计,将更多计算资源倾向给重要的前景token,减小信息损失,从而实现更高效的环视图3D检测器。nuScenes数据集上的大量结果表明,我们的方法几乎可以保持SOTA的性能,同时推理加速高达30%,并且在扩大ViT参数量和输入分辨率后,结论依然成立。

作者:Dingyuan Zhang, Dingkang Liang, Zichang Tan , Xiaoqing Ye, Cheng Zhang , Jingdong Wang , Xiang Bai

单位:华中科技大学,百度

WAS: Dataset and Methods for Artistic Text Segmentation

准确的文字分割结果对于文字相关的图像生成式任务(如文字图像生成、文本编辑、文本擦除和文字风格迁移)至关重要。近年来,一些场景文本分割方法在分割常规文本方面取得了显著进展。然而,这些方法在包含艺术文字的场景中表现较差。因此,本文着眼于更具挑战性的艺术文字分割任务,并构建了一个真实的艺术文字分割数据集。该任务的主要挑战为艺术文字的局部笔画形状多变且复杂,以及全局拓扑结构的复杂性。作者提出了一种具有逐层动量查询的解码器,以防止模型忽略特殊形状的笔画区域;还设计了一个骨架辅助头,以引导模型关注全局结构。此外,还提出了一种基于大型多模态模型和扩散模型的训练数据合成策略。实验结果表明,所提出的方法和合成数据集可以显著提升艺术文字分割的性能,并在其他公共数据集上取得了最先进的结果。

作者:Xudong Xie, Yuzhe Li, Yang Liu, Zhifei Zhang, Zhaowen Wang, Wei Xiong, Xiang Bai

单位:华中科技大学,Adobe

PartGLEE: A Foundation Model for Recognizing and Parsing Any Objects

PartGLEE是一个多层级的感知基础模型,旨在增强模型对图像中的物体及其对应的各个部分的识别与定位能力。该模型通过一个创新的Q-Former结构有效地构建并组织起物体与其组成部分之间的层级关系。PartGLEE不仅在部分层级的感知任务上表现卓越,同时也在传统物体层级的感知任务上保持了稳定的性能,这主要得益于其中的Q-Former架构以及重新整合后具有层级间对应关系的数据集。实验表明,PartGLEE在各种物体和部分层级的检测评估中均取得了优异的表现,突出显示了其卓越的多层级感知能力。这些能力使得PartGLEE能够实现更深入的图像理解,并可以通过提示(Prompt)的手段让多模态大型语言模型(mLLMs)对图像有更细粒度的理解能力。

作者:Junyi Li,Junfeng Wu,Weizhi Zhao,Song Bai,Xiang Bai

单位:华中科技大学,字节跳动

PSALM: Pixelwise SegmentAtion with Large Multi-Modal Model

PSALM将多模态大模型拓展到了分割任务上。为了克服 LMM 仅限于文本输出的限制,PSALM 增加了一个mask解码器和一系列精心设计的输入来处理各种分割任务。输入包括图像、任务指令、条件指令和一组mask tokens,这使得模型能够有效地生成和分类分割mask。PSALM 的灵活设计支持跨多个数据集和任务的联合训练,从而提高性能和任务泛化能力。PSALM 在几个分割基准测试中取得了优异的成绩,例如 RefCOCO /RefCOCO+/RefCOCOg、COCO 全景分割和 COCO-Interactive,并且在未见过的任务上展示了零样本能力,如开放词表分割、视频目标分割等。具体的代码已经开源在https://github.com/zamling/PSALM

作者:Zheng Zhang, Yeyao Ma, Enming Zhang, Xiang Bai

单位:华中科技大学,微软亚洲研究院

SC4D: Sparse-Controlled Video-to-4D Generation and Motion Transfer

当下2D/3D生成模型的最新进展使得单视图视频生成动态3D对象成为可能。现有的方法利用分数蒸馏采样(SDS)来将动态场景建模为动态NeRF或稠密的3D高斯。然而,由于NeRF的隐式特性以及稠密高斯运动预测的复杂性,这些方法难以在单视图条件下的参考图对齐、时空一致性和运动保真度之间取得较好平衡。为了解决这些问题,本文提出了一种高效、基于稀疏控制点的视频到4D框架,称为SC4D。该框架将运动和外观解耦,以实现卓越的视频到4D生成。此外,我们引入了自适应高斯(AG)初始化和高斯对齐(GA)损失,以解决几何退化问题,确保学习的运动和形状的保真度。综合实验结果表明,该方法在质量和效率上均优于现有方法。此外,通过对SC4D的运动和外观进行分离建模,我们设计了一种新颖的应用,能够根据文本描述将学习到的运动无缝地迁移到不同的4D实体上。

作者:Zijie Wu, Chaohui Yu, Yanqin Jiang, Chenjie Cao, Fan Wang, Xiang Bai

单位:华中科技大学,阿里巴巴达摩院

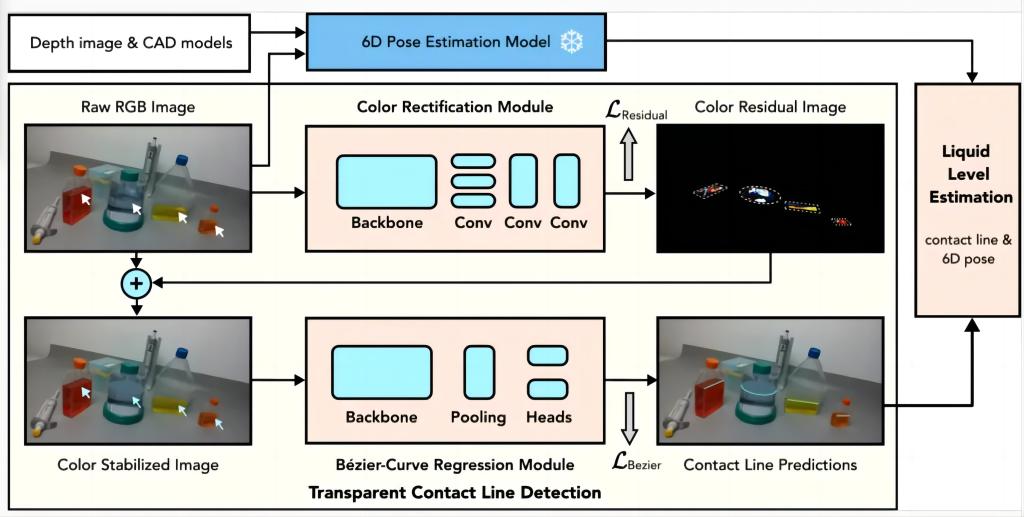

Towards Dual Transparent Liquid Level Estimation in Biomedical Lab: Dataset, Methods and Practices

在AI赋能的智能生物医学实验室中,准确估计容器内透明液体的高度对于液体分配、吸取和混合等实验任务至关重要。现有方法仅关注固定视角下的单个实例,与实际应用场景有较大差距。为此,夏教授团队提出了一种新的双透明液位高度估计Benchmark,包括数据集、方法和实践,提出的DTLD (Dual Transparent Liquid Level Estimation Dataset) 数据集包含27,458张图片,涵盖四种透明生物医学实验器皿,涉及多个视角。基于DTLD,团队提出了一种端到端的学习方法来检测液位接触线(Contact Line)并估计液位。为提高检测鲁棒性,还提出了一个液面修正模块。实验证明,此方法将液位估计的平均绝对百分比误差减少了43.4%。

作者:Xiayu Wang, Ke Ma, Ruiyun Zhong, Xinggang Wang, Yi Fang, Yang Xiao, Tian Xia

单位:华中科技大学,纽约大学阿布扎比分校

CoLA: Conditional Dropout and Language-driven Robust Dual-modal Salient Object Detection

深度/热信息对于使用传统RGB图像检测显著对象具有重要作用。然而,在双模态显著对象检测(SOD)模型中,抗噪输入和模态缺失的鲁棒性至关重要,但在过去很少有研究探讨这些因素对模型的影响。为了解决这个问题,本文提出了一个语言驱动的质量评估框架(LQA),用以应对噪声输入问题,并引入了一种基于条件舍弃(Conditional Dropout, CD)的训练方法来处理模态缺失。CD作为一种插件训练方案,将模态缺失视为条件,增强了各种双模态SOD模型的整体鲁棒性。大量实验表明,所提出的方法在模态完整和模态缺失的情况下均优于最新的双模态SOD模型。CoLA相关代码已经开源,欢迎同行交流与使用。

作者:Shuang Hao,Chunlin Zhong,He Tang

单位:华中科技大学