GPT-4因其展示的强大多模态能力而引发了对多模态大语言模型(MLLM)的研究热潮。多模态大语言模型是整合了文本和视觉处理能力的先进人工智能系统,旨在模仿人类的感知方式,结合图像和语言进行理解和推理,被认为是向通用人工智能迈进的关键步骤之一。11月,院长白翔教授团队发布了新的多模态大模型——Monkey。

通过专注于大分辨率,Monkey能够处理分辨率高达1344x896的图像。Monkey在大规模带有详细描述的高质量图文数据上进行了训练,帮助其炼就洞察图像细节的火眼金睛,取得了与Caption和QA任务相关的16个数据集的SOTA,甚至与GPT4V相比,在密集文本问答任务上也有着亮眼的表现。

Monkey强大的问答能力,能够准确地把握住问题并给出正确的回答,尤其是在密集文本问答任务上,目前的大模型或多或少都面临着一定的问题,Monkey为解决这一难题提供了一条可行的出路。

在探索过程中,白翔教授团队提出了两种方法。

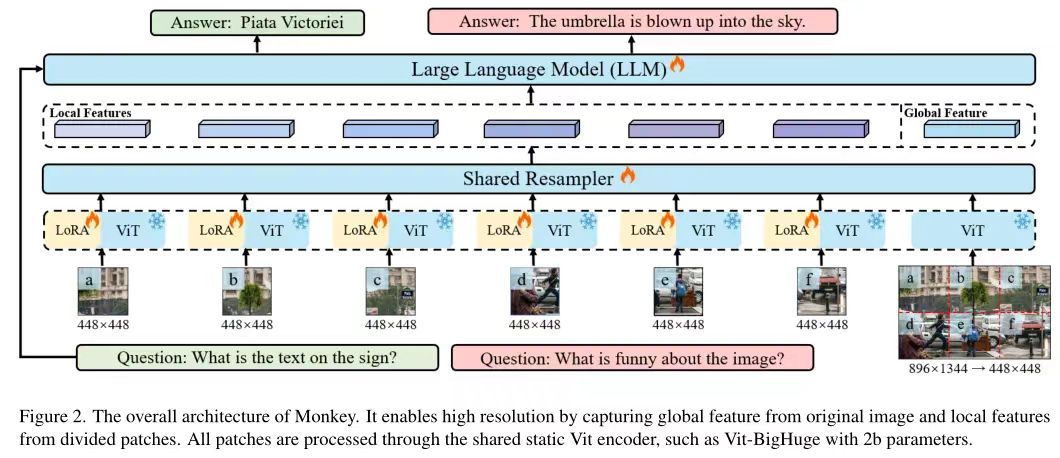

一是增大输入分辨率。

将原始输入图片裁剪成多个图片块,再将这些图片块和原始输入图片统一到448x448的尺寸。每个图片块经过视觉编码时会加入一个专属的Lora以此更好地提取图片块的局部视觉特征,训练时仅训练Lora部分,而原始的输入图像则用于提取全局特征,以此方法达到增大输入分辨率的目的。

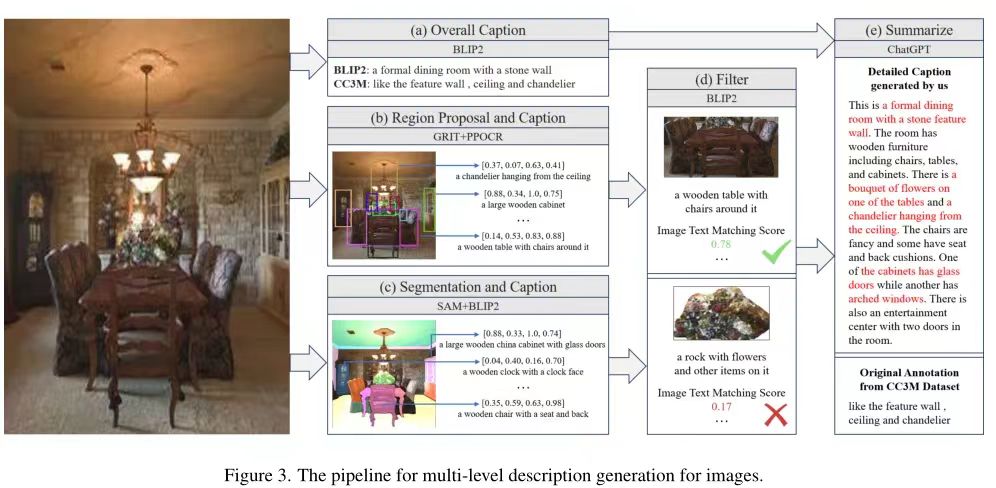

二是多级特征融合的详细描述生成方法生成高质量图文数据。

主要分为五个步骤:第一步,使用BLIP2对整张图生成全局描述;第二步用 GRIT生成区域框,并提供区域中对象的名称和详细描述,同时使用PPOCR提取区域的文本框坐标和文本内容;第三步使用SAM进行分割,并送入BLIP2生成对各个物体及其组成部分的详细描述;第四步使用BLIP-2 评估过滤掉低分匹配;最后使用ChatGPT 对上述得到的描述进行总结从而得到图像的详细描述。

通过这两种设计的协同作用,Monkey在多个基准测试中取得了出色的结果。在18个不同的数据集上进行测试的结果表明,Monkey拥有卓越的性能,在密集文本的问答任务上,可以根据问题的要求进行推理,能够适配中文问答;在文本较少的场景中,因其自身拥有丰富的知识库,可以根据问题进行外推,从而回答出正确的答案;在Caption任务上,不仅仅可以对图片进行准确详细的描述,同时能够合理发散,分析出图片所传达的一些抽象含义。这些充分地展现了Monkey能够很好地胜任图像描述生成、场景问答、以场景文本为中心的视觉问答和面向文档的视觉问答等任务。